支持向量机的对偶问题比原问题容易解决,在符合KKT条件的情况下,其对偶问题和原问题的解相同,这里我们结合李航博士的《统计学习方法》一书和林轩田老师的《机器学习技法》中的内容,介绍下SVM的对偶问题。本人无专业的数学学习背景,只能直观上理解一些问题,请数学专业的朋友不吝赐教。

前言

支持向量机的对偶问题比原问题容易解决,在符合KKT条件的情况下,其对偶问题和原问题的解相同,这里我们结合李航博士的《统计学习方法》一书和林轩田老师的《机器学习技法》中的内容,介绍下SVM的对偶问题。本人无专业的数学学习背景,只能直观上理解一些问题,请数学专业的朋友不吝赐教。 如有谬误,请联系指正。转载请注明出处。

e-mail: FesianXu@gmail.com

github: https://github.com/FesianXu

知乎专栏: 计算机视觉/计算机图形理论与应用

微信公众号:机器学习杂货铺3号店

SVM的原问题的拉格朗日乘数表示

我们在上一篇博文《SVM笔记系列1,SVM起源与目的》中,谈到了SVM的原问题,这里摘抄如下:

假设原问题为

这里我觉得有必要解释下为什么

SVM的对偶问题

从上面的讨论中,我们得知了SVM的原问题的最小最大表达形式为:

此时,我们得到了对偶问题的最大最小表述,同样的,我们试图去求解

求解

得出:

等价为求最小问题:

根据Karush–Kuhn–Tucker(KKT)条件2,我们有:

前两个式子我们已经在求极值的时候利用了,得知:

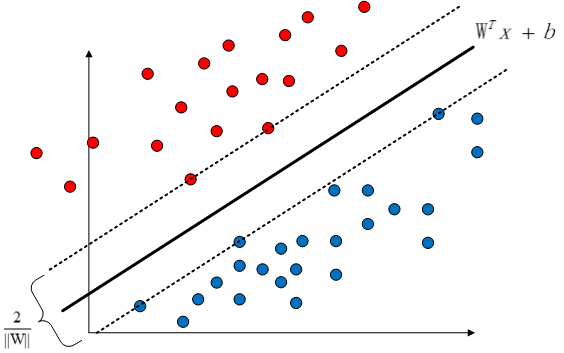

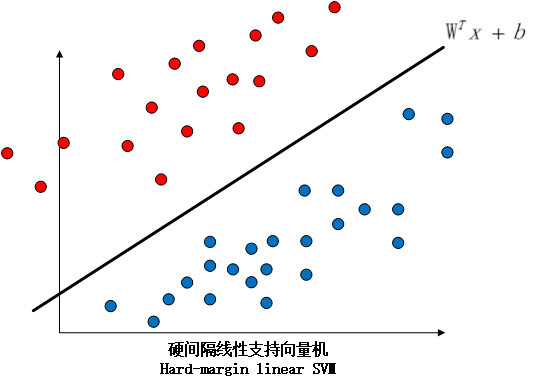

至此,我们得到了硬间隔线性支持向量机的数学表述形式,所谓硬间隔线性支持向量机,就是满足我之前的假设

两类样本是线性可分的,总是存在一个超平面

可以将其完美分割开。

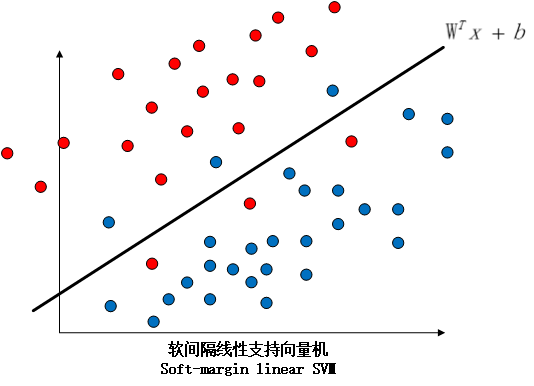

但是,在现实生活中的数据往往是或本身就是非线性可分但是近似线性可分的,或是线性可分但是具有噪声的,以上两种情况都会导致在现实应用中,硬间隔线性支持向量机变得不再实用,因此我们将会在后续讨论用以解决近似线性可分的软间隔线性支持向量机和基于kernel的支持向量机,后者可以解决非线性可分的问题。下图表示了硬间隔线性支持向量机和软间隔支持向量机之间的区别。

在下一篇中,我们紧接着现在的内容,介绍序列最小最优化算法(Sequential Minimal Optimization,SMO),用于求解

这里我们要记住我们需要最优化的目的式子,我们以后将会反复提到这个式子。 易证明。参考wikipedia的凸函数定义。↩︎ 事实上,如果